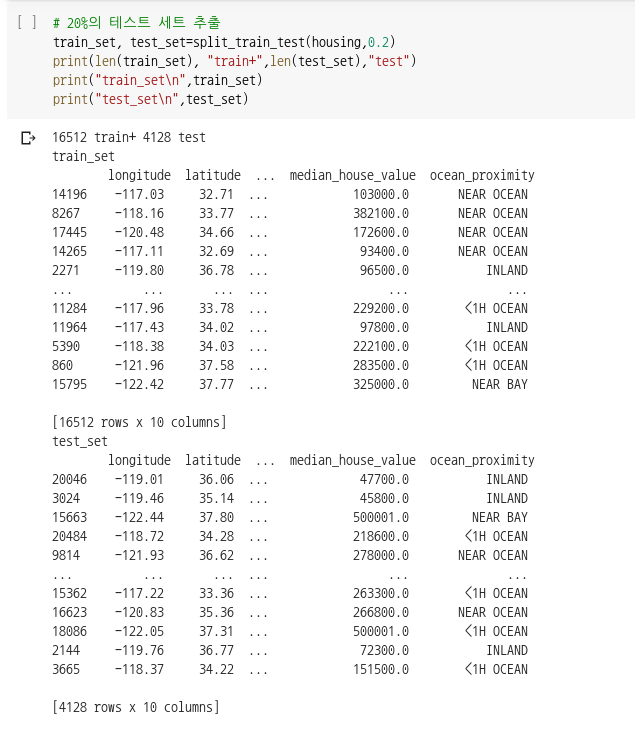

들어가며 지난 글에서는 모델을 구축하기 위한 주택 관련 데이터들을 다운로드하고 간단하게 데이터를 살펴보고 어떻게 데이터를 다룰지 알아보았습니다. 이번에는 데이터를 훈련 세트와 테스테 세트로 나누는 다양한 방법과 장단점에 대해서 설명하도록 하겠습니다. 2.1 테스트 세트를 만드는 이유 모델에 데이터를 훈련시키기 전에 주어진 데이터에서 테스트 세트를 추출하는 이유는 두 가지입니다. 첫째, 훈련 데이터로 학습된 모델을 평가하기 위해서입니다. 훈련 모델로만 학습된 모델이 얼마나 일반화되어있는지 평가하기 위해서는 훈련 데이터와 다른 데이터가 필요합니다. 둘째, 데이터 스누핑 편향(data snooping bias)을 방지하기 위해서 입니다. 만일 개발자가 모든 데이터를 이용해서 모델을 학습시키고 평가하여 정확도를..